Los robots son máquinas que pertenecen a los buscadores y se encargan de escanear tu web e indexar todas sus páginas y los contenidos. El archivo robots nos será de gran utilidad para controlar el acceso o la restricción de los robots en nuestras páginas y directorios. Nosotros decidimos qué contenido queremos que indexen y cuál no nos interesa indexar. Además, el archivo robots nos ayudará a eliminar los problemas de contenido duplicado.

Si necesitas ayuda para configurar el archivo robots.txt lo primero que debes conocer son sus dos elementos principales User-agent y Disallow.

User agent especifica el robot, como pueden ser “Gloogebot” para especificar el robot de google, o “*” para especificar el acceso a todos los robots.

Disallow indicará los contenidos que queremos que no se indexen en los buscadores. Pero para concretar su mayor o menor alcance debemos especificar:

Disallow: / prohíbe la entrada a toda la carpeta.

Disallow: /foro/ prohíbe la entrada al directorio foro.

Disallow: permite la entrada a toda la carpeta.

Deberás tener especial cuidado de no bloquear ciertos recursos de la web a la araña de Google. Ten en cuenta que cada CMS contiene unas características propias que afectan al archivo robots.

Aquí tenemos un archivo robots por defecto, sin modificaciones:

User-agent: *

Disallow: /index.php/

Disallow: /404/

Disallow: /admin/

Disallow: /api/

Disallow: /app/

Disallow: /catalog/category/view/

Disallow: /catalog/product/view/

Disallow: /catalog/product_compare/

Disallow: /catalogsearch/

Disallow: /cgi-bin/

Disallow: /checkout/

Disallow: /contacts/

Disallow: /customer/

Disallow: /downloader/

Disallow: /install/

Disallow: /images/

Disallow: /js/

Disallow: /lib/

Disallow: /magento/

Disallow: /media/

Disallow: /newsletter/

Disallow: /pkginfo/

Disallow: /private/

Disallow: /poll/

Disallow: /report/

Disallow: /sendfriend/

Disallow: /skin/

Disallow: /tag/

Disallow: /var/

Disallow: /wishlist/

Para configurar el archivo robot.txt para Magento, no debes olvidarte de excluir algunas líneas del robots, como son:

#Disallow: /js/

#Disallow: /lib/

#Disallow: /media/

#Disallow: /checkout/

#Disallow: /*.js$

#Disallow: /*.css$

Disallow: /*.php$

Disallow: /*?SID=

Con estas indicaciones le estamos diciendo a Google que indexe el JavaScrip y el Css. No podemos bloquearle este recurso, por lo que, si queremos, podemos eliminar directamente la línea del archivo robots, o bien escribirla tal y como en el ejemplo anterior. Con estas indicaciones le estamos diciendo a Google que indexe el JavaScrip y el Css.

Es importante que Google pueda acceder e indexar la carpeta “media”, en la que figuran todos los archivos multimedia, imágenes y fotografías de la web. Necesitamos que el buscador tenga en cuenta nuestra carpeta “lib” pues no es recomendable no indexar la librería.

Recuerda no olvidarte de consultar los cambios en WebMaster Tools, ahora Search Console, para asegurarte de que Google tenga acceso a los archivos JS y CSS.

Asegúrate de revisar los “recursos bloqueados” para evitar que se estén bloqueando ficheros importantes. Te aparecerá un listado de las páginas bloqueadas. Haciendo click en cada una de ellas Google te indicará lo que debes hacer para dejar de bloquearlas.

Si es así, debes modificar el archivo Robots.txt para que deje de hacerlo. Puedes hacerlo de manera manual o ayudándote de Plugins SEO.

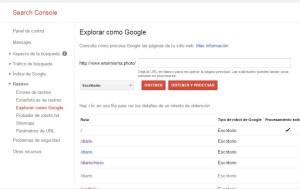

Explora tu web como lo haría Google desde el apartado “Explorar como Google”. Debemos explorar con cada una de las opciones que nos muestra el explorador de Google y comprobar como realmente está viendo el buscador nuestro site.

Cuando lo tengamos todo pulsaremos en el botón “Enviar al índice”.

Y ¡ya está!, así nos aseguraremos de que Google pueda rastrear sin problemas nuestra web.

Estoy intentando configurar mi robots.txt en magento. Estoy colgando el archivo en el directorio raíz / pero al teclear dominio.com/robots.txt , me muestra la página de inicio y Search Console no reconoce la existencia del archivo. ¿Dónde puede estar el problema? Me ocurre lo mismo con el sitemap, generado en magento pero no reconoce ni dominio.com/sitemap.xml ni (lo he cambiado a ver si) dominio.com/sitemap/sitemap.xml

Gracias